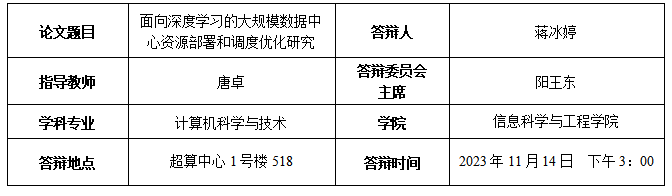

学位论文简介

为了更好的共享利用昂贵的GPU资源,大规模的GPU数据中心逐渐成为深度学习研究和商业应用的基础设施。然而,为了充分利用这些资源并确保高效性,综合的全栈式的优化是非常有必要的。如何高效的从底层的部署,到上层的利用和调度资源在大规模计算环境中变得尤为关键。为了应对以深度学习为应用基础的瞬时爆发的大规模计算需求带来的计算挑战,本文从大规模数据中心的快速部署、GPU资源的并发调度以及深度学习任务的GPU资源分配三个方面,展开了深入的研究和优化。本文的主要创新点如下:

从底层的基础设施出发,研究了大规模数据中心的云资源池快速部署。在面对大规模和瞬时的高计算需求时,智能分布式镜像仓库中心部署(IDRD)架构提供了一个独特的视角。该架构基于OpenStack使用多个仓库服务中心的容器化部署自适应地放置分布式镜像存储库。提出了一种服务器负载优先级算法来解决IDRD中的多仓库放置问题。此外,我们设计了一种基于需求密度的聚类算法,可以优化IDRD的全局性能,提高大规模集群的负载均衡能力。IDRD在天河超级计算环境中实现表明显著减少了OpenStack组件镜像分发时间,并提高了部署效率。

在GPU资源管理层,研究了数据中心GPU的内核并发调度策略。通过引入动态资源感知流和混合内核切片并发架构(DRASTIC),本研究成功地优化了GPU的并发性和资源利用率。针对不同的场景,我们提出了三种算法来调度多个混合内核切片和CUDA流,以充分利用GPU内的硬件并行性。DRASTIC同时考虑了这两个方面。它动态分配流资源,以提高GPU利用率,同时权衡多个流开销和优化性能。在此基础上,设计了数据块传输和内核统一管理的系统优化方案。与最先进的内核切片方法相比,DRASTIC方法显著提高了的整体性能。

在深度学习负载应用层,研究了面向多租户深度学习负载的数据中心的GPU资源分配问题。针深度学习作业在共享GPU集群中的调度与资源分配问题,本研究提出了Dike,一个信息不可知的框架,它设计了一个公平而有效的策略来调度和放置深度学习作业。Dike巧妙地利用了离散的混合优先级反馈队列,优先处理较小的作业以缓解集体拥堵,同时为大型作业提供不间断的资源。为了进一步提高数据中心的整体效率,我们提出了一种动态整合的沟通感知就业安置策略。它的目标是在优化作业执行性能和减少资源碎片之间进行明智的权衡。大规模跟踪驱动模拟表明,Dike的集群效率远高于最先进的调度器。

主要学术成果

Bingting Jiang, Zhuo Tang , Xiong Xiao, Jing Yao, Ronghui Cao, Kenli Li. Efficient and Automated Deployment Architecture for OpenStack in TianHe Super Computing Environment. IEEE Transactions on Parallel and Distributed Systems (TPDS, CCF A类). 2022.

Zhuo Tang, Bingting Jiang, Yaohua Wang, Yuanchun Liu, Kenli Li. Improving GPU Performance via Coordinated Kernel Slicing and Multi CUDA Streaming. Design Automation Conference 2022 (DAC, CCF A类).

Xiong Xiao, Zhuo Tang, Chuanying Li, Bingting Jiang, Kenli Li. SBPA: Sybil-based Backdoor Poisoning Attacks for Distributed Big Data in AIoT-based Federated Learning System. IEEE Transactions on Big Data (TBD, SCI 2区). 2022.